資訊內(nèi)容

重磅!MobileNetV3 來了!

點擊上方“計算機視覺life”,選擇“置頂”

本文轉(zhuǎn)載自我愛計算機視覺,禁二次轉(zhuǎn)載

在現(xiàn)代深度學(xué)習(xí)算法研究中,通用的骨干網(wǎng)+特定任務(wù)網(wǎng)絡(luò)head成為一種標(biāo)準(zhǔn)的設(shè)計模式。比如VGG + 檢測Head,或者inception + 分割Head。

在移動端部署深度卷積網(wǎng)絡(luò),無論什么視覺任務(wù),選擇高精度的計算量少和參數(shù)少的骨干網(wǎng)是必經(jīng)之路。這其中谷歌家去年發(fā)布的 MobileNetV2是首選。

在MobileNetV2論文發(fā)布時隔一年4個月后,MobileNetV3 來了!

這必將引起移動端網(wǎng)絡(luò)升級的狂潮,讓我們一起來看看這次又有什么黑科技!

昨天谷歌在arXiv上公布的論文《Searching for MobileNetV3》,詳細(xì)介紹了MobileNetV3的設(shè)計思想和網(wǎng)絡(luò)結(jié)構(gòu)。

先來說下結(jié)論:MobileNetV3 沒有引入新的 Block,題目中Searching已經(jīng)道盡該網(wǎng)絡(luò)的設(shè)計哲學(xué):神經(jīng)架構(gòu)搜索!

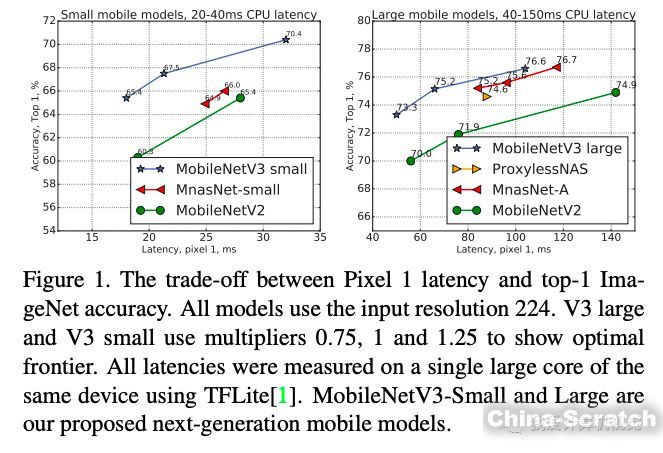

研究人員公布了 MobileNetV3 有兩個版本,MobileNetV3-Small 與?MobileNetV3-Large 分別對應(yīng)對計算和存儲要求低和高的版本。

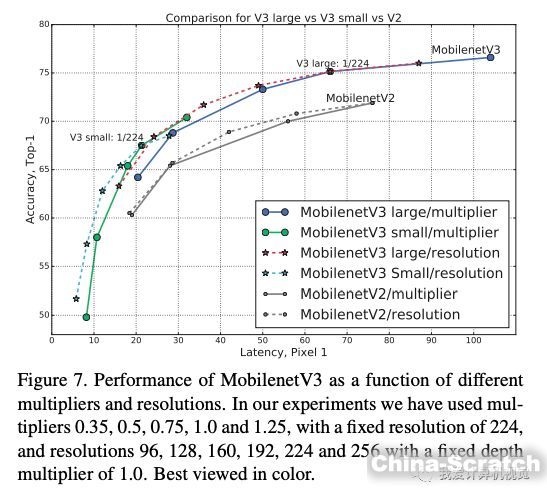

下圖分別是MobileNetV3兩個版本與其他輕量級網(wǎng)絡(luò)在Pixel 1 手機上的計算延遲與ImageNet分類精度的比較。可見MobileNetV3 取得了顯著的比較優(yōu)勢。

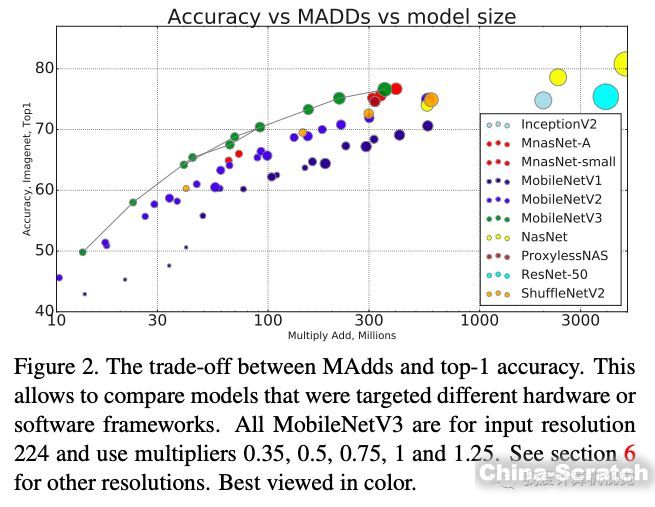

下圖是ImageNet分類精度、MADD計算量、模型大小的比較,MobileNetV3依然是最優(yōu)秀的。

高效的網(wǎng)絡(luò)構(gòu)建模塊

前面已經(jīng)說過,MobileNetV3 是神經(jīng)架構(gòu)搜索得到的模型,其內(nèi)部使用的模塊繼承自:

1. MobileNetV1 模型引入的深度可分離卷積(depthwise separable convolutions);

2. MobileNetV2 模型引入的具有線性瓶頸的倒殘差結(jié)構(gòu)(the inverted residual with linear bottleneck);

3. MnasNet 模型引入的基于squeeze and excitation結(jié)構(gòu)的輕量級注意力模型。

這些被證明行之有效的用于移動端網(wǎng)絡(luò)設(shè)計的模塊是搭建MobileNetV3的積木。

互補搜索

在網(wǎng)絡(luò)結(jié)構(gòu)搜索中,作者結(jié)合兩種技術(shù):資源受限的NAS(platform-aware NAS)與NetAdapt,前者用于在計算和參數(shù)量受限的前提下搜索網(wǎng)絡(luò)的各個模塊,所以稱之為模塊級的搜索(Block-wise Search)?,后者用于對各個模塊確定之后網(wǎng)絡(luò)層的微調(diào)。

這兩項技術(shù)分別來自論文:

M. Tan, B. Chen, R. Pang, V. Vasudevan, and Q. V. Le. Mnasnet: Platform-aware neural architecture search for mobile. CoRR, abs/1807.11626, 2018.?

T. Yang, A. G. Howard, B. Chen, X. Zhang, A. Go, M. Sandler, V. Sze, and H. Adam. Netadapt: Platform-aware neural network adaptation for mobile applications. In ECCV, 2018

前者相當(dāng)于整體結(jié)構(gòu)搜索,后者相當(dāng)于局部搜索,兩者互為補充。

到這里,我們還沒看到算法研究人員的工作在哪里(啟動訓(xùn)練按鈕?)

繼續(xù)往下看。

網(wǎng)絡(luò)改進(jìn)

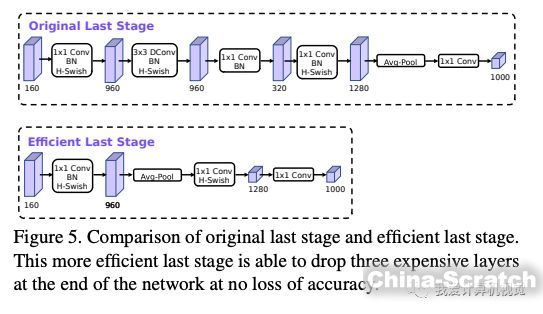

作者們發(fā)現(xiàn)MobileNetV2 網(wǎng)絡(luò)端部最后階段的計算量很大,重新設(shè)計了這一部分,如下圖:

這樣做并不會造成精度損失。

另外,作者發(fā)現(xiàn)一種新出的激活函數(shù)swish x 能有效改進(jìn)網(wǎng)絡(luò)精度:

但就是計算量太大了。

于是作者對這個函數(shù)進(jìn)行了數(shù)值近似:

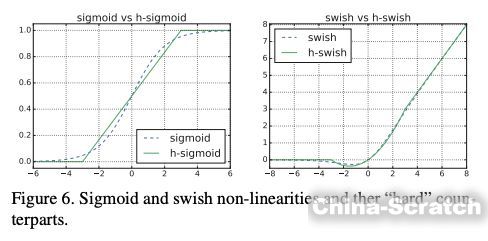

事實證明,這個近似很有效:

從圖形上看出,這兩個函數(shù)的確很接近。

MobileNetV3 網(wǎng)絡(luò)結(jié)構(gòu)!

這就是今天的主角了!

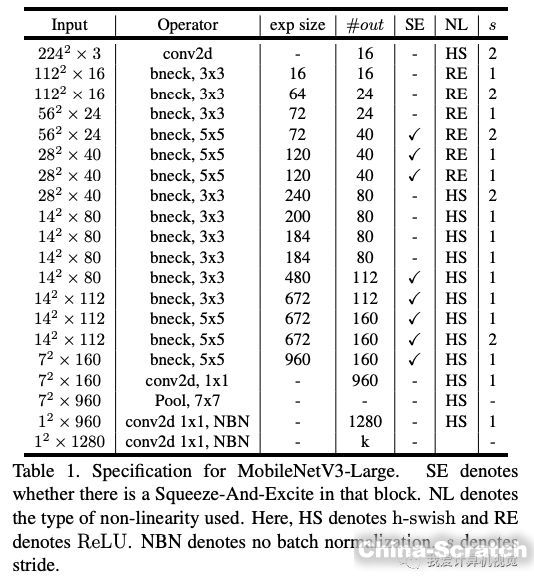

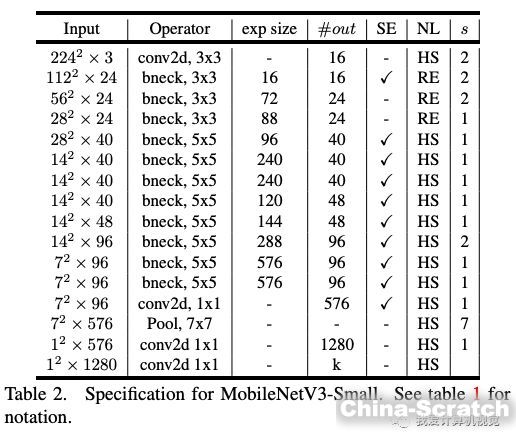

使用上述搜索機制和網(wǎng)絡(luò)改進(jìn),最終谷歌得到的模型是這樣(分別是MobileNetV3-Large和MobileNetV3-Small):

內(nèi)部各個模塊的類型和參數(shù)均已列出。

谷歌沒有公布用了多少時間搜索訓(xùn)練。

目前谷歌還沒有公布MobileNetV3的預(yù)訓(xùn)練模型,不過讀者可以按照上述結(jié)構(gòu)構(gòu)建網(wǎng)絡(luò)在ImageNet上訓(xùn)練得到權(quán)重。

實驗結(jié)果

作者使用上述網(wǎng)絡(luò)在分類、目標(biāo)檢測、語義分割三個任務(wù)中驗證了MobileNetV3的優(yōu)勢:在計算量小、參數(shù)少的前提下,相比其他輕量級網(wǎng)絡(luò),依然在在三個任務(wù)重取得了最好的成績。

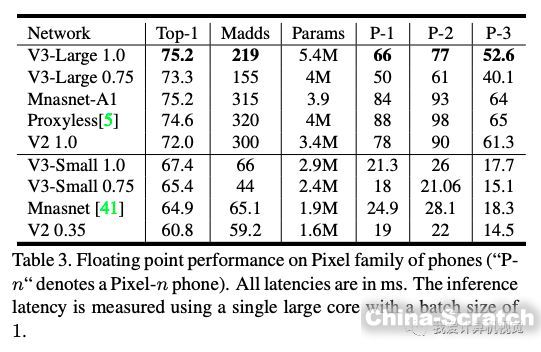

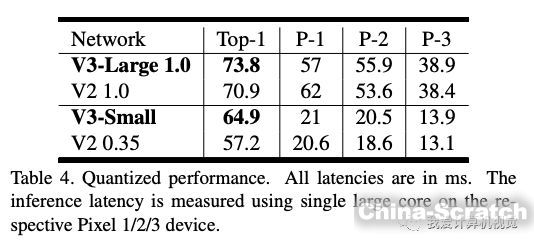

下圖是ImageNet分類Top-1精度、計算量、參數(shù)量及在Pixel系列手機實驗的結(jié)果:

下圖是與前一代MobieNetV2的比較結(jié)果:

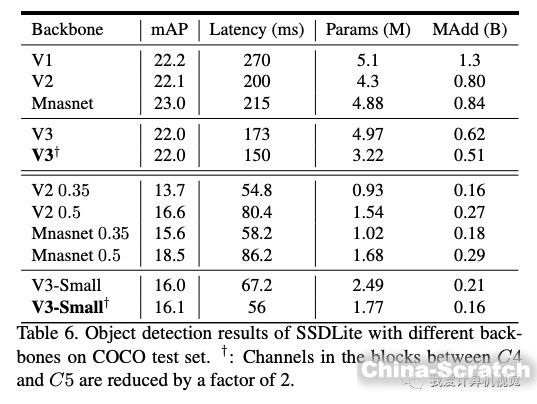

這是使用其構(gòu)筑的SSDLite目標(biāo)檢測算法在MS COCO數(shù)據(jù)集上的比較結(jié)果:

V3-Large取得了最高的精度,V3-Small 取得了V2近似的精度,速度卻快很多。

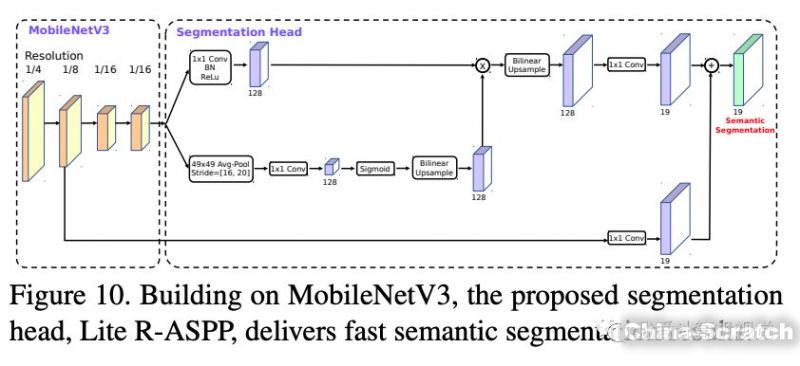

另外作者基于MobieNetV3設(shè)計了新的輕量級語義分割模型Lite R-ASPP:

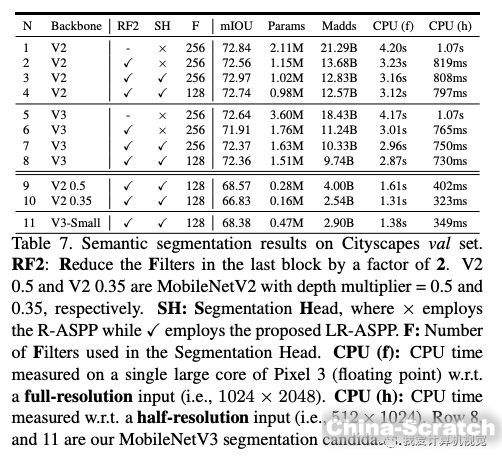

下圖是使用上述分割算法在CItyScapes驗證集上的結(jié)果比較:

精度提升不明顯,速度有顯著提升。

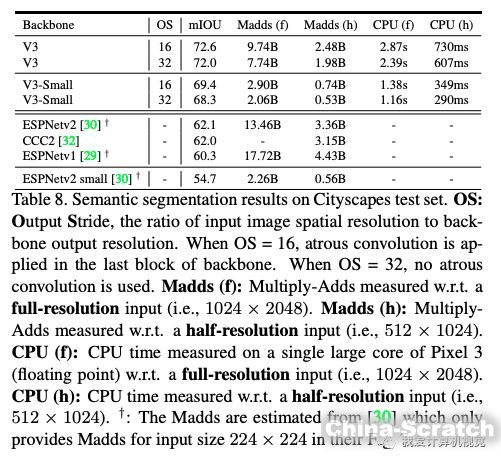

下圖是與其他輕量級語義分割算法的比較,MobileNetV3取得了不小的優(yōu)勢。

總結(jié)一下:

MobileNetV3-Large在ImageNet分類上的準(zhǔn)確度與MobileNetV2相比提高了3.2%,同時延遲降低了15%。

MobileNetV3-large 用于目標(biāo)檢測,在COCO數(shù)據(jù)集上檢測精度與MobileNetV2大致相同,但速度提高了25%。

在Cityscapes語義分割任務(wù)中,新設(shè)計的模型MobileNetV3-Large LR-ASPP 與 MobileNetV2 R-ASPP分割精度近似,但快30%。

期待谷歌早日將其預(yù)訓(xùn)練模型開源~

神經(jīng)架構(gòu)搜索火了,但感覺是不是算法設(shè)計也越來越乏味了。。。

歡迎發(fā)表你的看法。

推薦閱讀

CVPR2019 | Decoders 對于語義分割的重要性CVPR2019?|?R-MVSNet:?一個高精度高效率的三維重建網(wǎng)絡(luò)CVPR2019 | SiamMask:視頻跟蹤最高精度

CVPR 2019 | 用異構(gòu)卷積訓(xùn)練深度CNN:提升效率而不損準(zhǔn)確度

CVPR 2019 | 人大 ML 研究組提出新的視頻測謊算法

CVPR2019 | 醫(yī)學(xué)影像:MIT 利用學(xué)習(xí)圖像變換進(jìn)行數(shù)據(jù)增強CVPR 2019 | GeoNet:基于測地距離的點云分析深度網(wǎng)絡(luò)

CVPR2019 | 中科大&微軟開源:姿態(tài)估計新模型HRNet

CVPR 2019 | 京東提出 ScratchDet:隨機初始化訓(xùn)練SSD目標(biāo)檢測器

CVPR 2019 | 微軟亞研院提出用于語義分割的結(jié)構(gòu)化知識蒸餾

CVPR2019 | 6D目標(biāo)姿態(tài)估計,李飛飛等提出DenseFusion

CVPR 2019 | PointConv:在點云上高效實現(xiàn)卷積操作

CVPR 2019 | 圖像壓縮重建也能抵御對抗樣本

CVPR 2019 | 神奇的超分辨率算法DPSR:應(yīng)對圖像模糊降質(zhì)綜述 | CVPR2019目標(biāo)檢測方法進(jìn)展

聲明:本文章由網(wǎng)友投稿作為教育分享用途,如有侵權(quán)原作者可通過郵件及時和我們聯(lián)系刪除